البيانات الضخمة ما أهميتها وما أهمية الاسثمار في تحليلها .. وكيف ستؤثر في حياتنا وقراراتنا؟

"مع دخول إنترنت الأشياء بشكل تدريجي إلى حياتنا اليومية سيتم تحويل كل ما نقوم به من اختيارات إلى مجموعة بيانات. وعن طريق ربطها ببيانات مشابهة سنتمكن من استخدام الطاقة بكفاءة أعلى وتطوير عقاقير شخصية لأمراضنا وتحسين قدرتنا على الاتصال. ولكنها في الوقت نفسه ستحد من الخصوصية وستعمل تنبؤاتها على زيادة توجيه المجتمع. فلا فوائد دون تكاليف" - صلاح خاشقجي

مؤخرا نسمع كثيرا عن مصطلح البيانات الضخمة Big Data و سرعة انتشار هذا المجال في سوق العمل. و لكن هل تساءلنا ما هي البيانات الضخمة Big Data؟ لكي نتفق مبدئيا هناك اكثر من تعريف لمصطلح البيانات الضخمة Big Data وكما أوضح الاتحاد الدولي للاتصالات(ITU) بأنه لا يوجد تعريف دقيق للبيانات الضخمة . و بشكل عام فإننا حين نتحدث عن البيانات الضخمة فنحن نتحدث عن بيانات متعددة الأنواع والمصادر والأحجام.

ما هى أهمية البيانات الضخمة فى عالمنا اليوم وعالم المستقبل؟

تقدم البيانات الضخمة ميزة تنافسية للمؤسسات اذا أحسنت الأستفادة منها وتحليلها لانها تقدم فهما أعمق لعملائها ومتطلباتهم ويساعد ذلك على اتخاذ القرارات داخل المؤسسه بصوره أكثر فعالية بناء على المعلومات المستخرجة من قواعد بيانات العملاء وبالتالى زيادة الكفاءه والربح وتقليل الفاقد فابستخدام أدوات تحليل البيانات الضخمه أستطاعت وول مارت تحسين نتائج البحث عن منتجاتها عبر الأنترنت بنسبة 10-15% بينما فى تقرير لماكينزى-وهى شركة رائده فى مجال أستشارات الاعمال- ان القطاع الصحى بالولايات المتحدة لو كان يستخدم تقنيات تحليل البيانات الضخمة بفاعليه وكفاءه لكان قد أنتج أكثر من 300 مليون دولار أمريكى كفائض سنوى من ميزانيه الصحة ثلثيها بسبب خفض تكاليف الانفاق بنسبة 8% 4 و بحسب أستطلاع رأى سابق أجرته مؤسسه جارتنر أن 64% من الشركات والمنظمات أستثمرت فى تبنى أستخدام التقنيات الجديده للتعاطى مع البيانات الضخمة فى العام 2013

ولا تتوقف الأستفاده من البيانات الضخمة على المؤسسات والمشاريع التجارية بل تمتد الى مجالات عديدة منها الطاقه والتعليم والصحة والمشاريع العلمية الضخمة أبرزها مشروع الجينوم البشرى (دراسة كامل المادة الوراثية للبشر) والذى يحتوى على 25 ألف جين التى تحتوى بدورها على 3 مليار زوج من القواعد الكيميائيه المكونه للDNA

يعرف الخبراء البيانات الضخمة بأنها أي مجموعة من البيانات التي هي بحجم يفوق قدرة معالجتها باستخدام أدوات قواعد البيانات التقليدية من التقاط، ومشاركة ونقل، وتخزين، وإدارة و تحليل في غضون فترة زمنية مقبولة لتلك البيانات؛ و من وجهة نظر مقدمي الخدمات، هي الأدوات والعمليات التي تحتاجها المنظمات للتعامل مع كمية كبيرة من البيانات لغرض التحليل. الطرفان اتفقا على إنها بيانات هائلة لا يمكن معالجتها بالطرق التقليدية في ظل تلك القيود المذكورة آنفاً.

إليكم بعض التعاريف لمنظمات وجهات عالمية والتي تصف البيانات الضخمة:

تعرف شركة جارتنر (Gartner Inc) المتخصصة في أبحاث واستشارات تقنية المعلومات بأنها "الأصول المعلوماتية كبيرة الأحجام وسريعة التدفق وكثيرة التنوع، والتي تتطلب طرق معالجة مجدية اقتصادياً ومبتكرة من أجل تطوير البصائر وطرق اتخاذ القرارات".

كما تعرفها شركة (IBM) " تنشأ البيانات الضخمة عن طريق كل شيء من حولنا وفي كل الأوقات كل عملية رقمية وكل تبادل في وسائل التواصل الاجتماعي ينتج لنا البيانات الضخمة، تتناقلها الأنظمة، وأجهزة الاستشعار، والأجهزة النقالة البيانات الضخمة لها مصادر متعددة في السرعة والحجم والتنوع ولكي نستخرج منفعة معنوية من البيانات الضخمة نحتاج إلى معالجة مثالية، وقدرات تحليلية، ومهارات ".

أما المنظمة الدولية للمعايير(ISO) فتعرفها بأنها "مجموعة أو مجموعات من البيانات لها خصائصها الفريدة (مثل الحجم، السرعة، التنوع، التباين، صحة البيانات... إلخ) ، لا يمكن معالجتها بكفاءة باستخدام التكنولوجيا الحالية والتقليدية لتحقيق الاستفادة منها" .

ويعرفها الاتحاد الدولي للاتصالات (ITU) "يشير مصطلح البيانات الضخمة إلى مجموعات البيانات التي تتميز بأنها فائقة حجماً وسرعة أو تنوعاً، بالقياس إلى أنواع مجموعات البيانات المعهودة الاستخدام" .

بسبب الوقت والجهد والتكلفة الكبيرة التي تحتاجها البيانات الضخمة لتحليلها ومعالجتها اضطر التقنيون على الاعتماد على أنظمة الذكاء الاصطناعي Artificial Intelligence التي لديها القدرة على التعلم والاستنتاج ورد الفعل على أوضاع لم تبرمج في الآلة باستخدام خوارزميات معقدة للعمل عليها، بالإضافة إلى استخدام تقنيات الحوسبة السحابية لإتمام عملها.

عادة يكون المقصود به البيانات الضخمة هي البيانات التي تقاس بالبيتا بايت petabyte (ألف تيرا بايت) أو الايكسا بايت exabyte (مليون تيرابيات)؛ ووفقاً لــ IBM فإنها ابتداءاً من العام 2012 الميلادية فإننا يومياً ننشأ ما يقارب 2.5 كوينتيليون بايت من البيانات الضخمة (كوينتيليون هو الرقم واحد متبوعاً بثمانية عشرة (18)صفر ).

و للمعلومية تمت اضافة كلمة Big Data الى قاموس Oxford ككلمة انجليزية مستحدثة.

تصنيف البيانات الضخمة:

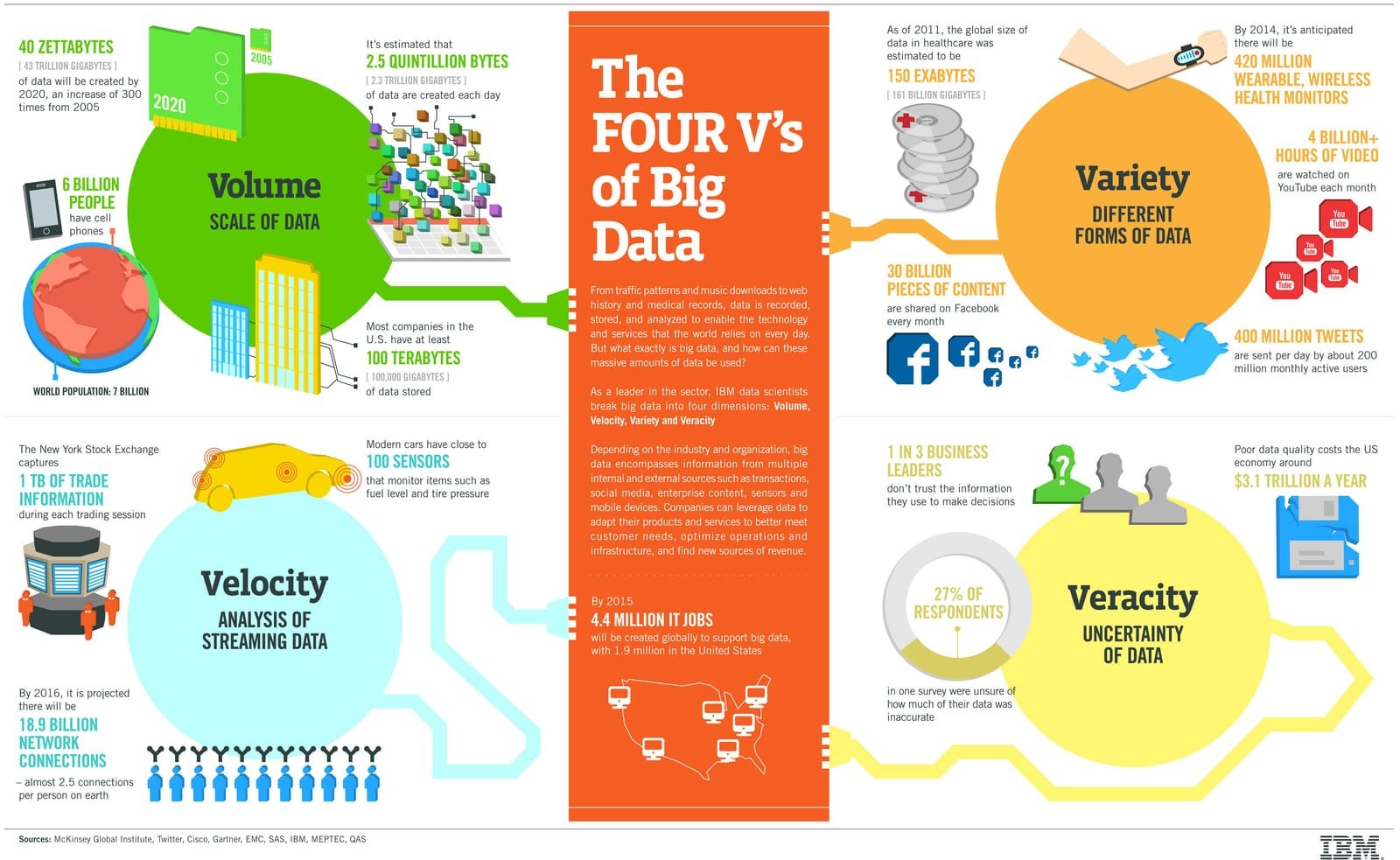

كثير منا يعتقد بأن البيانات الضخمة تصنف وفقا للحجم فقط، في الحقيقة هي تصنف وفقا لمبدأ (3V's) و يتكون من:

الحجم Volume:

وهي حجم البيانات المستخرجة من مصدر ما، وهو ما يحدد قيمة وامكانات البيانات لكي تصنف من ضمن البيانات الضخمة؛ و قد يكون الخاصية الأكثر أهمية في تحليل البيانات الضخمة .كما أن وصفها بالضخمة لا يحدد كمية معينة؛ فكما ذكرنا آنفا بأن الحجم يقاس عادة بالبيتا بايت او بالإكسا بايت. و للمعلومية بحلول العام 2020 سيحتوى الفضاء الإلكتروني على ما يقرب من 40.000 ميتابايت من البيانات الجاهزة للتحليل واستخلاص المعلومات؛ ويقدر أن %90 من البيانات الموجودة في العالم اليوم قد استحدثت خلال السنتين الأخيرتين، بواسطة أجهزة وعلى أيدي بشر ساهم كلاهما في تزايد البيانات.

التنوع Variety:

و يقصد بها تنوع البيانات المستخرجة، والتي تساعد المستخدمين سواء كاموا باحثين أو محللين على اختيار البيانات المناسبة لمجال بحثهم و تتضمن بيانات مهيكلة في قواعد بيانات و بيانات غير مهيكلة تأتي من طابعها غير الممنهج، مثل: الصور ومقاطع وتسجيلات الصوت وأشرطة الفيديو والرسائل القصيرة وسجلات المكالمات وبيانات الخرائط (GPS)... وضيرها الكثير؛ وتتطلب وقتاً وجهداً لتهيئتها في شكل مناسب للتجهيز والتحليل.

السرعة Velocity:

و يقصد بها سرعة إنتاج واستخراج البيانات لتغطية الطلب عليها؛ حيث تعتبر السرعة عنصراً حاسماً في اتخاذ القرار بناء على هذه البيانات، وهو الوقت الذي نستغرقه من لحظة وصول هذه البيانات إلى لحظة الخروج بالقرار بناء عليها. سابقا كانت الشركات تستخدم لمعالجة مجموعة صغيرة من البيانات المخزنة في صورة بيانات مهيكلة في قواعد بيانات عملية تسمى بال ” Batch Process“ حيث كان يتم تحليل كل مجموعة بيانات واحدة تلو الأخرى في انتظار وصول النتائج. مع الازدياد الضخم في حجم البيانات وسرعة تواترها أصبحت الحاجة أكثر إلحاحا الى نظام يضمن سرعة فائقة في تحليل البيانات الضخمة في الوقت اللحظي “Real Time“ أو سرعة تقارب الوقت اللحظي. أدت تلك الحاجة الى ابتكار تقنيات وحلول مثل Apache و SAP HANA و Hadoop وغيرها الكثير.

كما أضيف مؤخراً لتلك المبادئ الثلاث وفقاً لخصائص البيانات الضخمة "مبدأ صحة البيانات الضخمة": فيمثل التمتع بالقدرة على تقييمها عنصراً جوهرياً في وضع الأساس لاتخاذ القرارات الهامة بناءً عليها. ويجب الأخذ بالاعتبار تباين هذه البيانات وعدم التأكد من صحتها في عملية اتخاذ القرار.

مصادر البيانات الضخمة:

قامت اللجنة الاقتصادية لأوروبا، بتقديم تقرير بعنوان ”ماذا تعنيه البيانات الضخمة للإحصاءات الرسمية“ آذار مارس و قد أوردت فيه تصنيفا لمصادر البيانات الضخمة على النحو التالي:

المصادر الناشئة عن إدارة أحد البرامج، سواء كان برنامجا حكوميا أو غير حكومي، كالسجلات الطبية الإلكترونية وزيارات المستشفيات وسجلات التأمين والسجلات المصرفية وبنوك الطعام.

المصادر التجارية أو ذات الصلة بالمعاملات، الناشئة عن معاملات بين كيانين، على سبيل المثال معاملات البطاقات الائتمانية والمعاملات التي تجرى عن طريق الإنترنت بوسائل منها الأجهزة المحمولة.

مصادر شبكات أجهزة الاستشعار، على سبيل المثال، التصوير بالأقمار الصناعية، وأجهزة استشعار الطرق، وأجهزة استشعار المناخ.

مصادر أجهزة التتبع، على سبيل المثال تتبع البيانات المستمدة من الهواتف المحمولة والنظام العالمي لتحديد المواقع.

مصادر البيانات السلوكية، على سبيل المثال، مرات البحث على الإنترنت عن منتج أو خدمة ما أو أي نوع آخر من المعلومات، ومرات مشاهدة إحدى الصفحات على الإنترنت.

مصادر البيانات المتعلقة بالآراء، على سبيل المثال، التعليقات على وسائط التواصل الاجتماعي.

أمثلة من الواقع على البيانات الضخمة:

لدى واتس آب أكثر من مليار مستخدم، و يتم تداول اكثر من 42 مليار رسالة و حوالي 1.6 مليار صورة بشكل يومي.

فيسبوك تتعامل مع أكثر من 50 مليار صورة من مستخدميها.

جووجل Google تتعامل مع حوالي 100 مليار عملية بحث في الشهر.

أهمية البيانات الضخمة:

للبيانات الضخمة اهمية عالية فهي تقدم ميزة تنافسية عالية للشركات اذا استطاعت الاستفادة منها ومعالجتها لأنها تقدم فهما أعمق لعملائها ومتطلباتهم ويساعد ذلك على اتخاذ القرارات المناسبة و الملائمة داخل الشركة بطريقة أكثر فعالية و ذلك بناء على المعلومات المستخرجة من قواعد بيانات العملاء وبالتالي زيادة الكفاءة والربح وتقليل الخسائر.

فباستخدام تقنيات و أدوات تحليل البيانات الضخمة استطاعت وول مارت تحسين نتائج البحث عن منتجاتها عبر الأنترنت بنسبة 10-15% بينما في تقرير لماكينزى-وهى شركة رائدة في مجال استشارات الاعمال- ان القطاع الصحي بالولايات المتحدة لو كان يستخدم تقنيات تحليل البيانات الضخمة بفاعليه وكفاءه لكان قد أنتج أكثر من 300 مليون دولار أمريكى كفائض سنوى من ميزانيه الصحة ثلثيها بسبب خفض تكاليف الانفاق .

المصادر / صحيفة الاقتصادية/ مدونة البيانات الكبيرة/ موقع عالم البرمجة